苹果想方设法要做GPU、小米也推出了自己的芯片加上华为、三星,似乎大点的科技企业都迷上做芯片了,这不,谷歌也发布了一块宣称要比GPU和CPU快15-30倍,这节奏带得,是要颠覆现有硬件版图的节奏吗?

谷歌推了一块叫TPU的芯片

2016年的I/O 开发者大会上,谷歌公布了自己研发的定制化芯片——Tensor Processing Units (TPU) ,并且透露已经在公司内部的数据中心使用了将近一年。该定制化芯片主要用来加速公司的机器学习算法,而且会优化公司的TensorFlow机器学习架构,但其并未透露更多的内容。

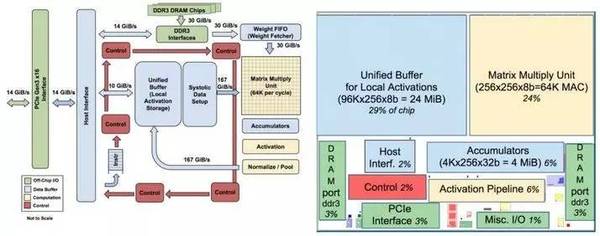

日前,谷歌在一份文件中介绍了更多关于该芯片的详细内容和一些使用标准。如果你是一个芯片设计者,你可以在该份文件中找到TPU工作的原理所在。谷歌方面表示TPU的运转速度很快,但这都是基于公司的数据进行的评估。

夸张的性能表现

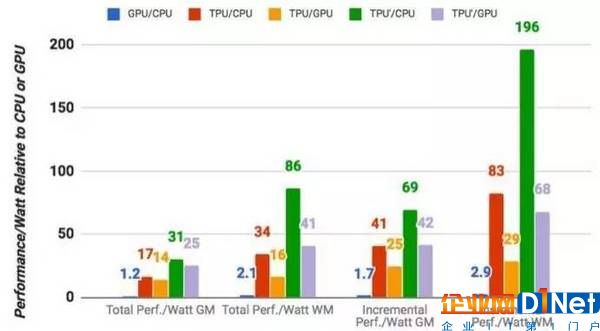

在运行谷歌常规的机器学习工作量的时候,TPU的平均运转速度要比标准的GPU/CPU组合(比如Intel的Haswell处理器和Nvidia 的 K80 GPU)快15-30倍。在数据中心计算功耗时,TPU还提供30-80倍的TeraOps/瓦特(如果未来使用更快的存储,这一数字可能还会提高)。

值得注意的是,这些数字是关于在生产中使用机器学习模型的,而不是首先创建模型。

Google还表示,大多数架构师为卷积神经网络(比如一种可以很好的识别图像的神经网络)优化了其芯片,但这些网络负责的工作量只占到公司数据中心总工作量的5%。事实上,大部分应用使用的是多层感知器。

谷歌说这块芯片让他们省了15个数据中心

谷歌表示公司从2006年就开始研究如何在数据中心中使用GPU、FPGA和定制的ASICS(这对定义TPU很重要)。然而,当时并没有很多的应用程序真的可以从这种特殊硬件中受益,因为他们所需的大量工作量可以在数据中心已经有的硬件中进行处理。

这种改变发生在2013年,公司当时预测DNN可能会变得越来越流行,这可能会使公司数据中心的计算需求增加一倍。如果用传统的CPU来满足这一计算量将变得很昂贵。因此,公司开始了一个优先项目,可以快速生成用于推理的定制ASIC(同时公司买了用于培训的现成GPU)。这样做的目的是,把芯片的性能提高10倍(比起GPU)。

对于谷歌来说,公司不太可能在自己的云端之外提供TPU。但公司表示,其他公司可以通过所掌握的技术进一步的提高进入这一领域的门槛。

随着人工智能、深度学习等技术的加入,行业里对芯片的要求也越来越高。像ARM、高通、英伟达这样的芯片公司在不断研发新的芯片。比如ARM此前推出了DynamlQ芯片,公司表示未来3年-5年,使用DynamlQ技术的Cortex-A系列处理器,其人工智能运算性能将提升50倍。而且可将CPU和SoC上特定硬件加速器的反应速度提升10倍。

英特尔他们怎么办

谷歌全球数据中心网络主管乌尔斯·霍勒泽(Urs H?lzle)表示,他们今后还将研发更多这样的芯片。

谷歌不会把这种芯片出售给其他公司,不会直接与英特尔或NVIDIA进行竞争。但谷歌拥有庞大的数据中心,是这两家公司迄今为止最大的潜在客户。与此同时,随着越来越多的企业使用谷歌提供的云计算服务,它们自己购买服务器(和芯片)的数量就会越来越少,也就给芯片市场带来进一步的冲击。

将GPU挤出局?

暂时来说,谷歌的深层神经网络将同时使用的TPU和GPU。霍勒泽不愿详细解释谷歌使用TPU的方式,只表示用TPU来处理Android手机语音识别所需要的“一部分计算”。但他说,谷歌将发布一篇阐述TPU好处的论文,而且谷歌将继续设计一些以其他方式推动机器学习的芯片。这样看上去,GPU似乎最终就会被挤出局。霍勒泽说,“GPU已经在一点点出局。GPU太通用了,对于机器学习针对性不强。机器学习本来就不是GPU的设计初衷 。”

NVIDIA可不想听到这样的话。作为全球最大的GPU厂商,NVIDIA正在推动自身业务向AI领域扩展。正如霍勒泽指出,NVIDIA最新的 GPU有一个专门针对机器学习的型号。但显然,谷歌希望进展能更大一些。

写在最后:芯片是项必要技能

谷歌、苹果、小米……越来越多的科技企业开始尝试向半导体芯片领域发起冲击,软件与硬件,尤其是芯片的融合,力图为用户带来更好的综合使用体验,这似乎成为了科技企业的发展方向,不过这样的方向,也为人们带来了更优秀的应用体验。

京公网安备 11010502049343号

京公网安备 11010502049343号