数据中心网络起着承上启下的作用,将计算和存储资源连接在一起,并以服务的形式对内部及外部的用户提供数据访问能力。虽说网络建设和运维投入远比机房基础建设、服务器设备、存储设备、应用开发及运维小,但大家最怕它出现性能问题或故障长时间不能恢复,因为网络一旦不可用,意味着一切服务都将停止。因此,设计运维一张高性能、高可靠的网络是网络架构及运维团队的首要目标。

结合我在锐捷网络服务互联网企业的实践经验,分享几个典型的网络架构设计,供大家参考。

数据中心10G/40G网络架构

主要设计理念:

a 核心设备全线速高性能转发,核心之间不互联,采用Fabric架构,隔离核心故障,

最大程度降低核心故障影响;

b 三层路由组网,通过ECMP提高冗余度,降低故障风险;

c 通过TOR上的服务器接入数量和上联40G链路数量控制单TOR收敛比,通过提高核心设备接口密度扩展单集群服务器规模。

注:千兆网络已跟不上业务发展,本文不再涉及。

适用网络

架构设计

架构特性

中小型

(集群规模300-1000台)

每台TOR 2*40GE上联2核心,OSPF组网;

IDC内收敛比6:1,集群带宽1.5Tbps ;

上联带宽根据集群规模灵活配置。

中型

(集群规模1000-10000台)

⦆ 每台TOR 4*40GE上联2核心,OSPF或BGP组网;

⦆ IDC内收敛比3:1,集群带宽30Tbps ;

⦆ 上联带宽根据集群规模灵活配置。

大型

(集群规模5000-20000台)

W 每台TOR 4*40GE上联4核心,BGP组网;

W IDC内收敛比3:1,集群带宽60Tbps;

W 上联带宽根据集群规模灵活配置。

超大型

(集群规模20000+台)

案 单POD集群规模300-1000台,数据中心集群规模20000+,BGP组网;

案 POD内收敛比6:1或3:1,单POD集群带宽1.5Tbps;

案 上联带宽根据集群规模灵活配置。

数据中心25G/100G网络架构

与10G/40G网络一致,主要变化在于:

a 下行链路由10G变为25G,提升至2.5倍;

b 上行链路每端口由40G变为100G,提升至2.5倍;

c 下一代主流芯片方案实现为48*25GE+8*100GE(Broadcom TD3),上行收敛比提升为1.5:1。

下面仅以大型数据中心为例做组网说明:

适用网络

架构设计

架构特性

大型

(集群规模5000-10000台)

CLOS网络架构

最后,想与大家分享的是今年国内不少互联网企业考虑使用的新架构设计。

从上述架构设计说明中,不难看出数据中心集群规模和收敛比,主要受限于机框式核心设备的端口密度,而业界核心设备的更新换代都是以数年为单位进行的,大大阻碍了数据中心规模和发展。另外,动辄数百个40GE接口或者100GE接口的核心设备单台运行功率已达20KW,而国内大部分IDC机房的平均功率只有5KW~6.5KW/机柜,这给机房供电系统的维护管理带来了极大的挑战。如何摆脱核心设备端口密度的限制?如何摆脱核心设备对IDC机房供电系统的挑战?

此时,CLOS架构诞生了。

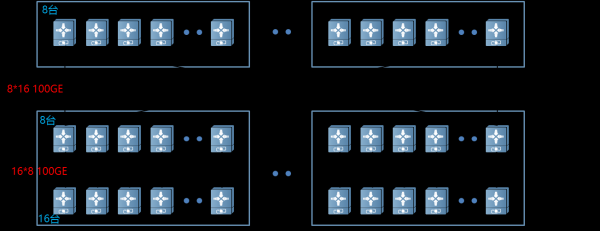

25G /100G CLOS网络架构图

架构特性:

Leaf、Fabric、Spine交换机选用中低端盒式交换机48*25GE+8*100GE/32*100GE;

每台Leaf,下联32个25GE做Server接入,8个100GE用于向上连接的上行链路;每个POD 16台Leaf交换机;

每台Fabric交换机, 有32个100GE,16个下连16台Leaf,16个上连至16组Spine;每个POD 8台Fabric交换机,共32个POD;

每台Spine交换机,有32个100GE,全部用于下连32个POD Fabric交换机;

每组8台,共16组Spine交换机;

通过Edge PODs连接外网,单POD集群带宽12.8Tbps,整数据中心集群带宽超过400Tbps。

随着智能时代的来临,大数据、人工智能等新技术的应用,对数据中心网络提出了新的挑战。如何更好地支撑Hadoop、RDMA等技术应用,成为网络运维团队关注和思考的问题。高性能、低时延、无损网络已然成为数据中心网络设计和运维的主流思路。

京公网安备 11010502049343号

京公网安备 11010502049343号