回顾2017年,常发表威胁论的马斯克也开始造芯片,英特尔发布Nervana神经网络处理器和人工智能芯片Loihi,英伟达推出进化版TITAN V 等等,这一年各个巨头可谓是在人工智能领域卯足了劲儿,经过这年如火如荼的积蓄,2018势必将是充满“硝烟”的一年。

关于人工智能的硬件,CPU,GPU,TPU(张量处理单元),甚至是FPGA,已经很难判断是谁开启了这场人工智能之战,要说谁将终结人工智能时代更是为时过早。但是2018年将是芯片制造商之间长期战斗的开始,在人工智能领域的硬件之争,怕是一定要决出个高下了。

当英特尔在Automobility LA 2017上宣布发布最新的人工智能硬件,这并不是对外发起挑战的意思。相反,它只是少数几个主要科技巨头的一系列最新技术更新,毕竟大家的目标都是在人工智能硬件领域打下坚实的基础。因为就目前的发展状况来看,人工智能将成为包括制造业、汽车、物联网、医疗甚至娱乐业在内的众多行业中的主导力量之一。

在硬件方面,人工智能被锁定在自己的“权力游戏”之中,不同的企业都在争夺霸主地位,创造出芯片架构,特别是在深度学习和神经网络方面以期获得优势。

据Research and Markets和TechNavio的分析师预测,全球AI芯片市场将在2017年至2021年间以年均54%的速度增长。

Technavio嵌入式系统研究首席分析师Raghu Raj Singh表示,“对能够满足深度学习的高功率硬件的需求是推动这一发展的关键驱动力。硬件的高增长率是由于对高计算能力的硬件平台的需求不断增长,这有助于运行深度学习的算法。初创企业和老牌企业之间日益激烈的竞争正在引领新的人工智能产品的发展,无论是硬件还是软件平台,都在运行着深度学习和算法。”

竞争正在升温。人工智能将成为计算硬件的下一个前沿领域,自从移动计算和互联网出现以来,人工智能可能是计算机硬件最重要的战场。

那么,我们是如何到达这里的,谁又是这其中的大玩家呢?

好的CPU

那些不需要人为干预的自动驾驶汽车,可能是有史以来最聪明、最复杂的机器之一。很显然,自动驾驶车辆已经成为人工智能的主要目标之一,而英特尔正在为这个目标不断奋斗。

英特尔并不仅仅是在内部进行研发工作,而是利用收购来使得在人工智能领域的脚步更稳。 2016年8月,英特尔收购了神经网络处理器制造商Nervana Systems。

谈到神经网络,它能够非常有效地执行各种各样的任务,但为了完成这些任务,首先必须教导网络如何执行这些任务。首先,神经网络执行要识别出狗的图片就必须明白狗的特征,并且了解它的所有品种。光从这一点上来看,就会十分耗费时间,可能会需要成千上万甚至数百万的狗的图像才能够完成相应的任务。

在2016年11月,在收购Nervana几个月后,英特尔宣布推出一系列处理器 - Nervana平台,直接针对人工智能相关的应用,例如训练神经网络。英特尔数据中心事业部执行副总裁兼总经理Diane Bryant表示,“我们期望英特尔Nervana平台能够产生突破性的性能,并大大缩短训练复杂神经网络的时间。在这个十年结束之前,英特尔将提供100倍的性能提升,这将在新兴的深度学习领域大大加速创新的步伐。”

今年3月,英特尔又在Mobileye公司进行了另一项引人注目的人工智能收购,这是一款基于机器学习的高级驾驶员辅助系统(ADAS)的开发,其价值约为150亿美元。英特尔收购的意义马上就显现了出来。这家芯片制造商希望在自动驾驶车辆领域占有一席之地,也许这样做也将自己定位为一个关键的机器学习硬件提供商。

在去年11月举行的洛杉矶Automobility LA贸易展览会上,英特尔首席执行官Brian Krzanich称自动驾驶是现今最大的游戏改变者,因为该公司宣布收购Mobileye公司后已经生产了一款新的SoC、EyeQ5。

Tera每秒运算(TOPS)是用于高性能SoC的通用性能指标。每瓦TOPS可以扩展该测量来描述性能效率。每瓦TOPS越高,芯片的效率越高。深度学习TOPS(DL)是指进行深度学习相关的操作的效率。根据英特尔的基于模拟的测试,EyeQ5预计将提供每瓦2.4 DL TOPS,是Nvidia的Xavier效率的两倍多,它的效率大约是每瓦执行1 DL TOPS。

英特尔自动驾驶集团(ADG)高级副总裁兼总经理Doug Davis在接受《设计新闻》时表示,“英特尔选择将重点放在每瓦特的DL型电脑上,因为它希望把重点放在处理器效率上,而不是其他指标。关注DL每瓦功耗是电源消耗的一个很好的指标,但是如果你考虑这个问题,它也会影响重量、成本和散热的问题,所以我们真的觉得效率是关注的重点。”

Davis补充表示,“总是围绕绝对性能进行大量的讨论,但是当我们考虑这个问题时,应该从更实际的角度出发,因为我们考虑了不同类型的工作量。深度学习是能够识别对象并做出决策,并尽可能快速有效地完成这一任务的关键。“

然而,英伟达公司已经对英特尔的数据提出了异议,尤其是考虑到EyeQ5的估计是基于模拟的,SoC将在两年内不可用。 今天所知道的是我们宣布的Xavier将于2018年初开始提供,相比于EyeQ5纯粹的24 TOPS两年后的模拟预测,30 TOPS的性能更高。

GPU是否注定要AI?

GPU制造商已经发现自己掌握着可能处于人工智能革命最前沿的技术。GPU曾被认为是CPU的补充单元(许多CPU将GPU集成到GPU中以处理图形处理),GPU已经扩展到以图形和视频为中心的领域之外,并进入深度学习领域,GPU制造商表示他们提供的性能远优于CPU。

▲Titan V GPU

虽然GPU市场上有少数几家公司,但似乎Nvidia更像这个技术的代名词。根据Jon Peddie研究公司的报告,Nvidia在2017年第三季度的GPU出货量上升了29.53%,主要竞争对手AMD和Intel都出局。AMD的出货量增加了7.63%,而Intel的出货量增加了5.01%。当然,这主要是由视频游戏市场推动的,但Jon Peddie Research的分析师认为,与加密货币挖掘有关的应用程序和对高端性能的需求也对出货量有所贡献。

对于能够处理需要高性能的特定任务的处理器(如加密货币挖掘和AI应用程序)的需求正是GPU发现自己处于AI硬件对话最前沿的原因。 GPU包含数百个可同时执行数千个软件线程的内核,同时比CPU更节能。尽管CPU是普遍化的并且倾向于跳跃,执行许多不同的任务,但是GPU擅长在大批量数据上一次又一次地执行相同的操作。

就在今年十二月份,Nvidia宣布推出了一款基于PC的GPU Titan V,专为深度学习而设计。新的GPU基于Nvidia的Volta架构,该架构利用了Nvidia称之为Tensor Cores的新型核心技术。Nvidia所做的是开发具有复杂架构,专门用于处理深度学习和神经网络计算的需求。

Titan V包含210亿个晶体管,能够提供110 teraflops的深度学习性能。 Nvidia将目标瞄准从事人工智能和深度学习的开发人员。Titan V.公司创始人兼首席执行官Jensen Huang在一次新闻发布会上表示,“Titan V是有史以来为个人电脑开发的最强大的GPU。我们对Volta的愿景是推动高性能计算和人工智能的外部极限。我们开发了新的处理器架构、指令、数字格式、内存架构和处理器链接。随着泰坦V的出现,我们把Volta推向世界各地的研究人员和科学家手中。”

一个由张量构成的世界

提到张量的概念,那就不得不提谷歌公司了。在过去的一年,这个搜索巨头发布了一个名为TensorFlow的深度学习开发的已经流行的开源框架。如Google所述,“TensorFlow是一个使用数据流图进行数值计算的开源软件库。图中的节点表示数学运算,而图边表示在它们之间通信的多维数据阵列(张量)。灵活的体系结构允许您使用单个API将计算部署到桌面、服务器或移动设备中的一个或多个CPU或GPU上。”

▲Google的张量处理单元(TPU)

TensorFlow的机器学习应用程序库包括面部识别、计算机视觉,当然还有其他应用程序中的搜索,在2016年的时候就已经被证明非常流行,以至于2016年英特尔一直致力于优化其处理器来运行TensorFlow。在2017年,谷歌还发布了针对移动和Android开发者的精简版TensorFlow。

但Google没有让软件成为人工智能野心的终点。在2016年,该公司发布了第一代称为张量处理单元(TPU)的新处理器。 Google的TPU是一个专为机器学习而设计的ASIC,专为运行TensorFlow而量身定制。而第二代TPU在今年五月份宣布,据Google称,它能够提供高达180 teraflops的性能。

作为加拿大多伦多第44届计算机体系结构国际研讨会(ISCA)的一部分,Google于2017年6月发布了一项研究报告,将其在数据中心部署的TPU与Intel Haswell CPU和部署在同一数据中心的Nvidia K80 GPU进行了比较, TPU平均比GPU和CPU执行速度快15到30倍。每瓦TPU的TOPS也高出约30到80倍。 Google表示,TPU正在推动其所有在线服务,如搜索、街景、Google相册和Google翻译。

在一份详细介绍最新热塑性聚氨酯(TPU)的文章中,Google的工程师们表示,早在六年前,当Google发现自己将深度学习融入越来越多的产品时,热塑性聚氨酯的需求就出现了。Google工程师认为,“如果我们假设人们每天只使用Google语音搜索三分钟,并且在我们正在使用的处理单元上运行深度神经网络来处理语音识别系统,那么我们必须加倍的增加Google的数据中心!”

Google的工程师在设计TPU时表示,他们采用了他们所说的“收缩性设计”。“这种设计被称为收缩性的,因为数据通过芯片流动,这让人想起心脏泵血的方式。矩阵乘法单元MXU中的特殊类型的脉动阵列针对执行矩阵乘法时的功率和面积效率进行了优化,不适合于通用计算,于是它做了一个工程折衷:限制寄存器、控制和操作的灵活性,以换取效率和更高的操作密度。”

在一些非常高端的AI应用中,TPU也已经证明了自己。 TPU是Google著名的AlphaGo AI背后的大脑,在去年击败了世界冠军,引起人们对于人工智能的关注。经过短短几个月的训练,AlphaGo的最新版本AlphaGo Zero就能够将自己的能力远远超过人类专家。对于国际象棋(一个复杂的游戏,但是比Go要小得多),在几个小时内的训练之后也能达到比较显著的效果。

FPGA - AI竞赛中的黑马

那么,TPU是AI的未来,对吗?微软认为,在可扩展性和灵活性方面,基于FPGA的解决方案可能将优于CPU、GPU或TPU提供的解决方案。

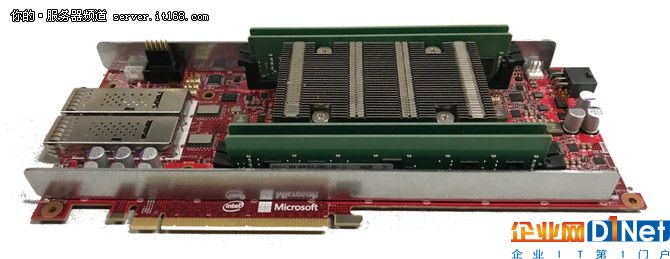

▲微软的Project Brainwave以39.5万亿次浮点运算的速度运行,在英特尔层的10个fpga上运行时,它的延迟时间还不到一毫秒

尽管基于处理器的解决方案在某种程度上由于其设计而局限于特定的任务,但是由于FPGA的灵活性和可编程性,所以或许可以使用FPGA来提供更容易的升级和更好的性能。根据微软的说法,在Intel Stratix 10 FPGA上运行时,微软的Project Brainwave以39.5 teraflops的速度执行,延时不到1毫秒。

FPGA是否为人工智能提供最佳选择与其他方面一样值得商榷。微软认为创造人工智能专用ASIC的生产成本太高,而另一些人则认为FPGA将永远无法完全实现专为人工智能设计的芯片性能。

在3月份的“现场可编程门阵列国际研讨会”(ISFPGA)上发表的一篇文章中,一组来自英特尔加速器架构实验室的研究人员评估了两代英特尔FPGA(Arria10和Stratix 10)与Nvidia Titan X Pascal Titan V)处理深度神经网络(DNN)算法。据英特尔研究人员称:“我们的研究结果显示,Stratix 10 FPGA的性能(TOP / sec)比Titan X Pascal图形处理器在[矩阵乘法](GEMM)操作上的性能提高了10%、50%甚至5.4倍。在Ternary-ResNet上,Stratix 10 FPGA可以比Titan X Pascal GPU提供60%的性能提升,性能功耗比提高2.3倍。我们的结果表明,FPGA可能成为加速下一代DNN的首选平台。”

谁将戴上皇冠?

在这个特定的时间点,就整体性能而言,很难不争论这些硬件在人工智能领域的表现,也很难不比较巨头们之间的表现。但是,就小编的粗浅认识来看,很多硬件并不是单纯的谁取代谁的角色,可能面对不同的用户、不同的细分领域就会有不同的选择,

就落地的应用来说,自动驾驶汽车正在成为将人工智能应用于更广泛的公众意识中,这可能是机器人、制造业、甚至娱乐领域的进步,真正推动人工智能的发展,但这并不是为了阻断新兴应用的诞生之路。

当发展步入正轨时,它可能不是一家企业主宰人工智能领域,未来可能会看到硬件领域的争斗越来越激烈,也或许是别的,时间会证明一切。

京公网安备 11010502049343号

京公网安备 11010502049343号