交互设计工具网站Readme的老板格里高利·科贝格。

心理健康聊天机器人Woebot的创始人艾莉森·达西。

患者正在接受虚拟心理治疗师艾莉(Ellie)的辅导。

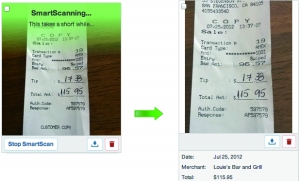

▲“智能扫描技术”(SmartScan)号称能够智能扫描出文字。

一些APP号称可以将语音转化成文字,结果却是人工操作。

(上接B01版)

分析

为何对“伪人工智能”趋之若鹜?

随后,《卫报》分析了这些科技企业对“伪人工智能”趋之若鹜的原因。

吸引关注和投资

首先便是装成行业佼佼者,吸引关注和投资,“这是他们不会告诉投资者和用户的秘密”。这其中又分两种情况。一种是让人类来协助已有的人工智能,比如牵涉到谷歌邮箱泄密的那些第三方App,再比如,美国有家叫Scale API的公司,雇了一大堆人帮自己的自动驾驶汽车校准传感器。

再有便是对外假称是AI技术,然后偷偷用人工代替,直到真的开发出这个AI之前,能混一天算一天。报道称,真人虽然速度又慢,又不能批量处理任务,但毕竟便宜啊。

有趣的是,早在2016年,一家交互设计工具网站Readme的老板格里高利·科贝格便在推特上用玩笑的口吻曝光了这个黑幕。他说:

“如何创办一家AI公司?

1.雇佣一批人类假装AI,他们的工资能多低就多低。

2.坐等AI被开发出来。”

模拟AI的最终体验

心理学家、心理健康聊天机器人Woebot的创始人艾莉森·达西表示,“你模拟它最终的体验。很多时候,在人工智能背后,其实是有真人在背后,而不是一个算法。”

艾莉森·达西说,开发一个好的AI系统需要“大量的数据”,一些设计师想在投资之前知道他们开发的服务是否有足够大的需求。

不过,她说,这种方法不适合像Woebot这样的心理支持服务。“作为心理学家,我们需要遵循道德准则,不欺骗别人显然应该是准则之一。”

《华尔街日报》13日再次评论了“伪人工智能”现象,称其为“机器学习”热潮和“零工经济”相结合的产物。

难题

如何加强AI技术“透明度”?

此外,《卫报》认为还有一个不那么“功利”的原因。心理学家发现,当用户以为自己面对的是机器人时,会更容易放下戒备。一旦涉及敏感话题,这种情况就更加明显。

再说回谷歌邮件事件,如果大家听说邮件只是被机器人偷看了,抵触情绪定然会比得知真相后小得多。

对AI更容易放下戒备

类似情形还存在于医疗问诊中、来自南加大的研究团队用他们开发的虚拟心理治疗师艾莉(Ellie)做了一番测试。他们发现,患有创伤后应激障碍的退伍军人知道艾莉是个AI系统时,他们更容易表露自己的症状,假如他们得知是真人在背后操作机器,就没那么容易了。

但是有些人认为,公司应该始终对自己的服务运营方式保持透明。

“我不喜欢这样。这对我来说是不诚实,是欺骗。”一位被雇佣去假装提供人工智能服务的员工透露,其实很多同行都有不同程度的抵触情绪。“感觉我们被推到了幕后。我不喜欢一家公司使用我的劳动力,转而向客户撒谎,不告诉他们真正发生的事情。”

让AI假装自己是人类

确实掌握AI技术的谷歌,也在早前意识到了这个伦理难题。而他们的解决方案是:让AI假装自己是人类。

谷歌在5月初宣布,“谷歌助手”(Google Assistant)的新功能Google Duplex会在打电话时加入“嗯”、“呃”之类拟人的象声词。但这一改动迅速遭到强烈反对,用户纷纷表示“这岂不骗得更厉害了”。

达西也对当时的设计很不满,“万一AI能模仿名人或政客的声音,打出真假难辨的电话,那还得了?”

于是,谷歌随后又做了改动,让Google Duplex在对话一开始就自报机器人身份,加强AI技术“透明度”。

但达西指出,“人工智能已经让人产生了很大的恐惧,在缺乏透明度的情况下,它并不能真正帮助人们进行对话。”

京公网安备 11010502049343号

京公网安备 11010502049343号