事实上,这种缺乏信任是众所周知的许多人工智能工作失败的核心之一:尤其是IBM Watson肿瘤解决方案(Watson for Oncology)。

专家们很快就解决了这个问题。“IBM试图将其超级计算机程序推广给IBM Watson肿瘤解决方案(Watson for Oncology)是一场公关灾难,”Google和Avantgarde Analytics创始人的UX研究员Vyacheslav Polonski博士说。 “ Watson肿瘤解决方案的问题在于医生根本不相信它。”

当Watson的结果与医生的结论达成一致时,才能被医生认可,但并没有帮助达到诊断的层面。而当Watson的结论不统一时,医生们只是认为IBM Watson的结果是错误的。

但如果医生知道它的结论如何得出的,结果可能会有所不同。“人工智能的决策过程通常对大多数人来说太难理解,” Polonski博士说道。“与我们不理解的事物互动会让人引起焦虑,让我们有种失控感。”

需要解释性

如果肿瘤学家已经了解Watson如何提出答案的——业界称之为“可解释性”,那么他们的信任程度可能会更高。

在医疗保健以外的许多情况下,可解释性现已成为人工智能的关键要求。以Twitter为例,“我们需要更好地解释我们的算法是如何工作的。理想情况下打开它们,以便人们可以真正看到它们的工作方式。对于任何人来说这都不容易,”Twitter首席执行官杰克·多尔西说。“事实上,人工智能的整个研究领域称为'可解释性',试图理解如何使算法解释他们如何做出决策。”

在其他情况下,人们呼吁AI做出生死攸关的决定。在这种情况下,可解释性绝对至关重要。

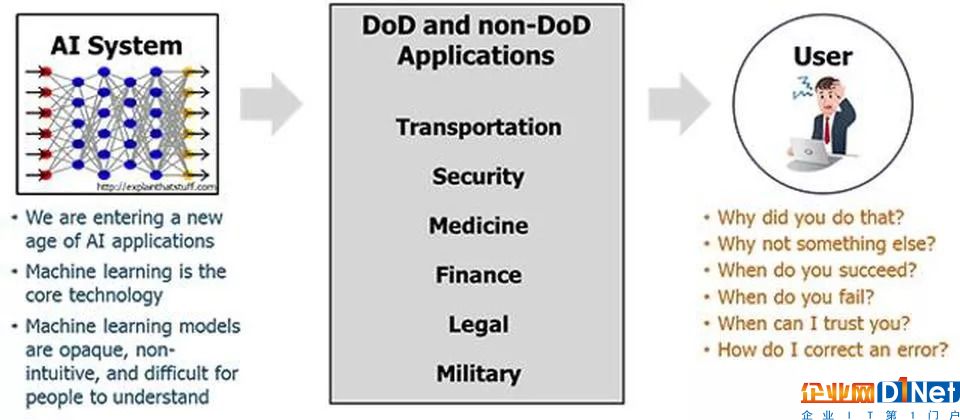

因此,美国国防部(DoD)正在投资解释性人工智能(XAI)并不奇怪。“可解释的人工智能——特别是可解释的机器学习——如果未来的战士要了解,适当信任并有效管理新一代人工智能机器合作伙伴,将是必不可少的,”国防高级研究计划局(DARPA)项目经理David Gunning解释道。“新的机器学习系统将能够解释他们的理由,描述他们的优势和劣势,并传达他们对未来行为的理解。”

然而,医疗保健仍然是AI最有前途的领域之一。“可解释的AI对我们医疗保健来说非常重要,实际上弥合了这个差距,无法了解可能会发生什么,可能会对人类的健康产生什么影响,并且实际上作为一种工具为临床医生提供服务,使他们真正感到舒适,并了解如何“使用人工智能”。联合健康集团OptumLabs应用数据科学中心副主席Sanji Fernando表示,“这就是为什么我们认为学术界,学术机构,大公司以及联邦政府内部都有一些令人惊奇的工作要做,以安全地批准这种决策。”

可解释性权衡

虽然像DARPA这样的组织正在积极投资XAI,但是有一个悬而未决的问题是,这些努力是否会降低使AI算法更好的核心优先级。

更令人担忧的是:我们是否需要“弱”AI算法以使其可解释?加利福尼亚大学欧文分校计算机科学助理教授Sameer Singh指出:“算法越准确,解释就越困难,尤其是深度学习。”“计算机越来越成为我们生活中更重要的一部分,随着时间的推移,自动化将逐渐得到改善,因此了解为什么这些复杂的AI和ML系统正在做出他们的决策变得越来越重要。”

因此,一些人工智能研究工作可能与其他人进行交叉目的。“系统越复杂,它的解释就越少,”奥塔哥大学博士后研究员,可解释人工智能研究员John Zerilli说。“如果你希望你的系统可以解释,你将不得不使用一个不那么强大或准确的简单系统。”

然而,DARPA投资于其所谓的“第三波AI系统”的20亿美元可能足以解决这种权衡问题。“XAI是当前DARPA少数计划之一,旨在实现'第三波AI系统',其中机器了解其运行的环境和环境,并随着时间的推移构建基础解释模型,使其能够表征现实世界现象,”DARPA的Gunning补充道。

京公网安备 11010502049343号

京公网安备 11010502049343号